)

)

Introducción

El debate de "local vs nube" a menudo se reduce a costo o control. En realidad, la estrategia de infraestructura se trata de alinear los modelos de alojamiento con el comportamiento de la carga de trabajo, las obligaciones de cumplimiento, la capacidad del equipo y la tolerancia al riesgo. Una estrategia de TI sólida también evita el pensamiento de dependencia: muchas organizaciones operan un entorno híbrido por diseño, no por accidente, porque diferentes cargas de trabajo tienen diferentes requisitos. Este artículo ayuda a los equipos de TI a tomar esa decisión de manera consistente y a defenderla con criterios claros.

TSplus Prueba gratuita de acceso remoto

Alternativa definitiva a Citrix/RDS para acceso a escritorio/aplicaciones. Seguro, rentable, en las instalaciones/nube

¿Qué es la infraestructura local en 2026?

La infraestructura local se refiere a la computación, el almacenamiento y la red alojados en instalaciones que su organización controla, como una sala de servidores, un centro de datos privado o un espacio de colocación. A menudo es donde TSplus Acceso Remoto se implementa para publicar aplicaciones y escritorios de Windows de manera segura. El equipo de TI se encarga del ciclo de vida de principio a fin: adquisición, parches, monitoreo, estrategia de respaldo y renovación de hardware.

¿Cuáles son las fortalezas de la infraestructura local?

La infraestructura local suele ser la mejor opción cuando el rendimiento predecible, la localización de datos y el control profundo de la configuración son innegociables. Muchos sistemas heredados y de línea de negocio también funcionan de manera más confiable en entornos locales estables donde las dependencias están bien entendidas. Para los equipos de seguridad, lo local puede simplificar ciertas decisiones de gobernanza porque los límites de la red y la custodia física son explícitos.

Las ventajas comunes incluyen:

- Consistente LAN latencia para aplicaciones y periféricos estrechamente acoplados

- Controles claros de residencia y localización de datos para cargas de trabajo reguladas

- Personalización de pila completa para segmentación, identidad híbrida y dependencias heredadas

¿Cuáles son los límites comunes de la infraestructura local?

La infraestructura local se escala en pasos, no de forma instantánea. Los plazos de entrega del hardware, las ventanas de mantenimiento y los ciclos de renovación pueden ralentizar la entrega, mientras que los entornos de larga duración pueden acumular deuda técnica si se retrasan las actualizaciones. Operativamente, el entorno local requiere personal continuo para parches, respuesta a incidentes, seguridad física y planificación de capacidad, lo que puede ser un desafío para los equipos de TI reducidos.

Las restricciones típicas incluyen:

- Planificación de capacidad y retrasos en la adquisición cuando se necesitan nuevos recursos rápidamente

- Mayor carga operativa para parches, monitoreo, copias de seguridad y seguridad física

- Riesgo de ciclo de actualización cuando se posponen las actualizaciones de hardware

¿Qué es la infraestructura en la nube y cuáles son los principales modelos?

La infraestructura en la nube ofrece servicios de computación, almacenamiento y plataforma a través de internet, generalmente a través de proveedores como Microsoft Azure, AWS o Google Cloud. En lugar de comprar hardware, las organizaciones provisionan servicios bajo demanda y pagan a través de facturación basada en el uso, suscripciones o capacidad reservada.

¿Cómo cambian IaaS, PaaS y SaaS la responsabilidad operativa?

Los modelos de nube trasladan la responsabilidad según el nivel de abstracción. IaaS proporciona máquinas virtuales y redes, dejando al cliente responsable de los sistemas operativos, la identidad y la seguridad de las aplicaciones. PaaS reduce el esfuerzo operativo al gestionar los tiempos de ejecución y las actualizaciones a nivel de plataforma. SaaS va más allá al ofrecer aplicaciones completas donde el cliente se centra principalmente en la configuración, el acceso de usuarios y la gobernanza de datos.

Una forma sencilla de enmarcar el cambio:

- IaaS: el camino más rápido para levantar y trasladar, pero aún eres responsable del endurecimiento y la aplicación de parches del sistema operativo

- PaaS: menos partes móviles para operar, pero las limitaciones de la plataforma aumentan

- SaaS: mínimo sobrecarga de operaciones, pero la personalización y la portabilidad se reducen

¿Por qué importa el modelo de responsabilidad compartida para la seguridad?

La seguridad en la nube depende de límites de propiedad correctos. Los proveedores protegen la infraestructura subyacente, pero los clientes siguen siendo responsables de la identidad, los permisos, la configuración y los controles de protección de datos. El acceso mal configurado y las políticas inconsistentes se encuentran entre las fuentes más comunes de exposición en la nube, por lo que las migraciones a la nube deben priorizar la gobernanza de identidad y las líneas base de seguridad, no solo la reubicación de cargas de trabajo.

Donde los equipos de TI deben rendir cuentas:

- Gestión de identidad y acceso (MFA, privilegio mínimo, acceso condicional)

- Control de exposición de red (puntos finales públicos, reglas de entrada, segmentación)

- Protección de datos ( cifrado gestión de claves, políticas de respaldo y retención

¿Cómo se comparan las soluciones locales y en la nube en criterios clave de TI?

Una comparación útil no es “cuál es mejor”, sino “cuál es mejor para esta carga de trabajo y este modelo operativo”. Las diferencias a continuación reflejan dónde cada modelo tiende a crear ventajas o costos ocultos.

¿Cómo difieren los costos y la presupuestación (CapEx vs OpEx)?

La infraestructura local generalmente requiere una mayor inversión inicial en hardware, licencias, instalaciones y tiempo de implementación. Ese costo puede justificarse cuando las cargas de trabajo son estables y están dimensionadas correctamente, porque la utilización predecible puede ofrecer un valor eficiente a largo plazo. La infraestructura en la nube reduce el costo inicial y puede mejorar la agilidad financiera, pero los costos pueden aumentar cuando los entornos están siempre activos, sobredimensionados o mal gobernados. El control de costos en la nube generalmente requiere disciplina de etiquetado, políticas de dimensionamiento y revisiones de costos regulares en lugar de decisiones de compra únicas.

La planificación de costos generalmente se reduce a:

- Cargas de trabajo estables: la optimización en las instalaciones o las reservas en la nube pueden funcionar bien.

- Cargas de trabajo variables: la elasticidad en la nube puede reducir la sobrecompra

- Costos ocultos: salida de la nube, crecimiento no gestionado del almacenamiento y recursos inactivos

¿Cómo difieren la seguridad, el cumplimiento y la residencia de datos?

La infraestructura local proporciona control directo sobre la ubicación de los datos, la segmentación y el acceso físico, lo que puede ayudar en industrias con estrictos requisitos de localización. La infraestructura en la nube también puede cumplir con los requisitos de cumplimiento, pero exige una configuración constante y sólida. controles de identidad a través de cuentas, suscripciones y servicios. Para entornos regulados, la pregunta más práctica a menudo es si la organización puede hacer cumplir la política y el registro de manera más confiable en un modelo que en el otro, dado las herramientas disponibles y la capacidad del equipo.

Diferencias clave que los líderes de TI deben validar:

- Residencia de datos: dónde se almacenan los datos sensibles y cómo se aplica la ubicación

- Auditabilidad: consistencia de registros, retención y evidencia de controles de acceso

- Gestión de exposición: qué tan rápido se detectan y remedian las configuraciones incorrectas

¿Cómo difieren el rendimiento y la latencia?

La infraestructura local puede ofrecer un rendimiento de LAN consistente para sistemas estrechamente acoplados y dependencias locales. La infraestructura en la nube funciona bien para equipos distribuidos y servicios accesibles globalmente, pero las cargas de trabajo sensibles a la latencia pueden requerir una colocación cuidadosa de la región, patrones de borde o componentes locales. Los resultados de rendimiento dependen menos de la palabra "nube" y más de las elecciones de arquitectura, como el diseño de red, los niveles de almacenamiento y el comportamiento de la aplicación bajo carga.

Controladores de rendimiento a verificar:

- Proximidad del usuario: ¿son los usuarios locales, regionales o globales?

- Mapeo de dependencias: ¿qué servicios deben permanecer cerca unos de otros para evitar problemas de latencia?

- Diseño de red: conectividad privada, enrutamiento y limitaciones de ancho de banda

¿Cómo difieren la escalabilidad y la velocidad de entrega?

La infraestructura en la nube generalmente gana en velocidad de aprovisionamiento y elasticidad. Se pueden crear nuevos entornos rápidamente para desarrollo, pruebas y picos de capacidad temporales, y luego apagarse cuando no se necesitan. La infraestructura local aún puede escalar, pero el escalado a menudo implica ciclos de adquisición, instalación física y ventanas de cambio, lo que es más lento pero a veces más predecible.

La escalabilidad generalmente se ve así:

- Nube: escalar rápidamente, luego reducir cuando la demanda disminuya

- En las instalaciones: escalar a través de pasos de crecimiento planificados y márgenes de capacidad

- Híbrido: mantener núcleos estables en las instalaciones, aumentar o expandirse en la nube cuando sea necesario

¿Cómo difieren las operaciones, el parcheo y las habilidades?

La infraestructura local requiere una amplia propiedad interna: ciclo de vida del hardware, hipervisores, almacenamiento, redes, parches, monitoreo y seguridad física. La infraestructura en la nube traslada las operaciones físicas al proveedor, pero aumenta la necesidad de gobernanza y habilidades de plataforma, como la gestión de identidades, políticas como código, gestión de postura de seguridad y optimización de costos en la nube. En la práctica, la nube reduce ciertas cargas operativas mientras aumenta la importancia de la estandarización y la automatización.

Las diferencias operativas suelen surgir en:

- Carga de trabajo del día 2: cadencia de parches, cobertura de monitoreo y respuesta a incidentes

- Conjuntos de habilidades: ingeniería de infraestructura frente a gobernanza de la nube y operaciones de plataforma

- Estandarización: plantillas, líneas base de configuración y madurez de la automatización

¿Cómo difieren la continuidad del negocio y la recuperación ante desastres?

La infraestructura local puede lograr una fuerte continuidad, pero a menudo requiere un segundo sitio, diseño de replicación y pruebas de conmutación por error regulares. La infraestructura en la nube ofrece bloques de construcción resilientes, pero la recuperación ante desastres aún depende de la disciplina arquitectónica, incluidas las políticas de respaldo, la planificación en múltiples regiones y los procesos de recuperación de identidad. El factor decisivo no es "dónde se ejecuta", sino "qué tan a fondo se ingenia y prueba la continuidad".

Puntos de control prácticos de DR incluyen:

- Definido RTO/RPO por aplicación, no por centro de datos

- Procedimientos de restauración y conmutación por error probados, no solo libros de ejecución documentados

- Planificación de recuperación de identidad (cuentas, claves y rutas de acceso privilegiadas)

¿Por qué es la infraestructura híbrida la predeterminada para muchas estrategias de TI?

La infraestructura híbrida es común porque los portafolios de aplicaciones son mixtos por naturaleza. Algunas cargas de trabajo son modernas y elásticas, mientras que otras son heredadas, reguladas o están estrechamente acopladas a redes locales. Las estrategias híbridas permiten a los equipos de TI modernizarse a diferentes velocidades sin forzar reescrituras arriesgadas o migraciones apresuradas.

¿Qué cargas de trabajo suelen permanecer en las instalaciones?

A menudo, las instalaciones locales se mantienen para aplicaciones empresariales heredadas, sistemas con dependencias de hardware especializadas, entornos con estrictas restricciones de residencia de datos y cargas de trabajo que se ejecutan continuamente con una utilización estable. También es común que las organizaciones mantengan los núcleos de autenticación, los servicios de directorio o los almacenes de datos sensibles más cerca de los controles de gobernanza central, dependiendo de los modelos de riesgo.

Patrones de carga de trabajo comunes de "permanecer en las instalaciones":

- Aplicaciones heredadas con dependencias frágiles o arquitecturas no soportadas

- Hardware especializado, periféricos o entornos adyacentes a OT/edge

- Cargas de trabajo de alta estabilidad que funcionan 24/7 con demanda predecible

¿Qué cargas de trabajo suelen trasladarse primero a la nube?

La nube a menudo es una buena opción para nuevas aplicaciones, entornos de desarrollo y prueba, pipelines de CI, herramientas de colaboración, análisis elásticos y cargas de trabajo que deben atender a usuarios distribuidos. La adopción de la nube también es común cuando TI necesita aprovisionamiento más rápido, plantillas estandarizadas y escalado más fácil entre regiones.

Patrones de carga de trabajo comunes de "mover primero":

- Cargas de trabajo de desarrollo/pruebas y CI que se benefician de la aprovisionamiento rápido

- Servicios orientados al cliente que requieren escalabilidad y resiliencia regional.

- Analítica o cargas de trabajo por lotes que se escalan hacia arriba/abajo según la demanda

¿Cómo eliges el modelo de infraestructura adecuado?

Un buen marco de elección es repetible y basado en la carga de trabajo. Debe ayudar a los equipos de TI a producir respuestas consistentes sin depender de preferencias individuales o narrativas de proveedores.

¿Qué preguntas de decisión deberían hacer los líderes de TI?

Elija un conjunto repetible de preguntas y aplíquelo a cada carga de trabajo. Eso mantiene las decisiones de "nube vs local" basadas en requisitos, no en preferencias, y facilita las aprobaciones en toda la seguridad. finanzas , y operaciones.

- ¿Cuáles son los objetivos de tiempo de actividad y recuperación de la carga de trabajo (RTO/RPO)?

- ¿Son estrictas las restricciones de residencia de datos o auditoría?

- ¿La demanda es estable o altamente variable?

- ¿Es la carga de trabajo sensible a la latencia?

Combina eso con la realidad operativa, porque la mejor plataforma en papel falla si la gobernanza y las operaciones del día 2 no pueden mantenerse.

- ¿Qué estándares de identidad y MFA deben aplicarse en todas partes?

- ¿Puede el equipo mantener la aplicación de parches, la supervisión y la respuesta a incidentes?

- ¿Cómo evitarán los controles de costos en la nube la expansión?

- ¿Qué nivel de dependencia del proveedor es aceptable?

¿Cuál es un método simple de mapeo de carga de trabajo a plataforma?

Califique cada carga de trabajo del 1 al 5 en cinco factores: estricta residencia de datos, sensibilidad a la latencia, variabilidad de la demanda, preparación para la modernización y costos operativos. Las cargas de trabajo con estricta residencia y alta sensibilidad a la latencia a menudo favorecen las instalaciones locales o la nube privada.

Las cargas de trabajo con demanda variable y una fuerte disposición a la modernización a menudo favorecen la nube pública. Las puntuaciones mixtas suelen indicar híbrido, donde la carga de trabajo se divide por componentes o se migra en fases con una identidad y monitoreo consistentes.

Cómo TSplus ayuda a conectar el acceso local, en la nube y híbrido?

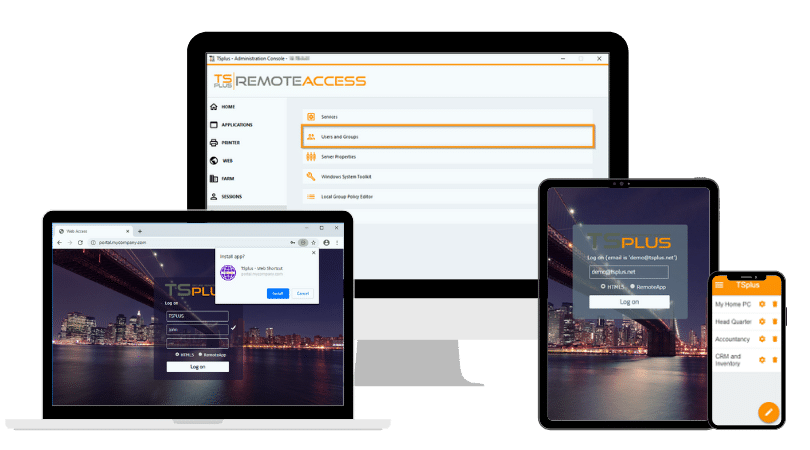

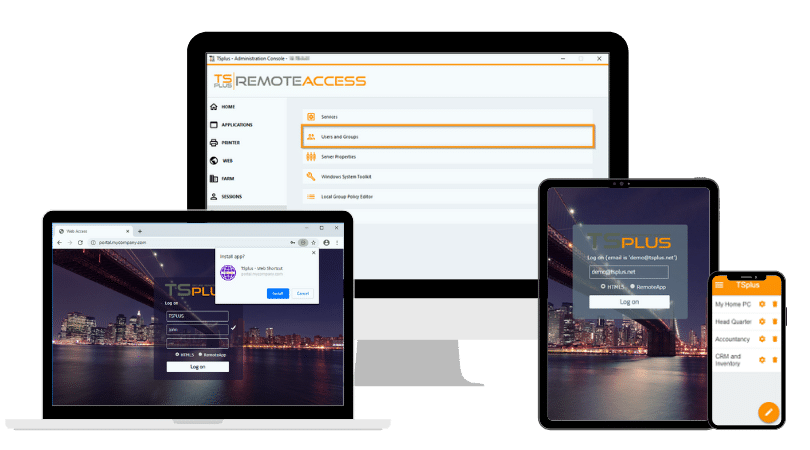

TSplus ayuda a las organizaciones a estandarizar el acceso seguro a aplicaciones y escritorios de Windows en entornos locales, en la nube y híbridos al simplificar la publicación de aplicaciones, mejorar la consistencia del acceso remoto y apoyar capas de seguridad prácticas que reducen la exposición mientras mantienen las implementaciones manejables para equipos de TI de pequeñas y medianas empresas y del mercado medio.

TSplus Acceso Remoto soporta la entrega centralizada para escritorios remotos y aplicaciones publicadas, de modo que los usuarios obtienen un punto de entrada consistente incluso cuando las cargas de trabajo permanecen en las instalaciones o se trasladan a máquinas virtuales en la nube. Este enfoque también reduce la fragmentación del acceso entre sitios, mejora la visibilidad administrativa y facilita mantener las políticas de autenticación y sesión alineadas a medida que evoluciona la infraestructura.

Conclusión

La infraestructura local sigue siendo una opción sólida cuando el control, la localidad y el rendimiento predecible son lo más importante. La infraestructura en la nube suele ser el mejor camino para la agilidad, el acceso distribuido y la entrega rápida cuando la gobernanza es fuerte. La infraestructura híbrida es frecuentemente la estrategia más realista porque adapta diferentes cargas de trabajo a diferentes requisitos sin forzar interrupciones. La estrategia de TI más efectiva es la que se mantiene consistente: criterios claros de carga de trabajo, controles de identidad disciplinados y prácticas operativas que son sostenibles a lo largo del tiempo.

TSplus Prueba gratuita de acceso remoto

Alternativa definitiva a Citrix/RDS para acceso a escritorio/aplicaciones. Seguro, rentable, en las instalaciones/nube

)

)

)